Herramientas de usuario

Ocultar Menú

−Barra lateral

clase:iabd:pia:2eval:tema08.intervalo_confianza

−Tabla de Contenidos

8.e Intervalos de confianza

Cuando calculamos una métrica realmente no tenemos el valor real de la métrica sino un valor (llamado estimador) que nos ayuda para saber el verdadero valor de la métrica.

El valor real de la métrica no lo podemos obtener pero si al menos in intervalo en el que es probable que esté ese valor real. A ese intervalo se le llama el intervalo de confianza.

En este prospecto médico para un test de COVID se muestran los intervalos de confianza la para la sensibilidad y la especificidad: sars-cov-2_rapid_antigen_test_es.pdf.

Los datos que se muestran son los siguientes:

E=115=NºdeenfermosS=311=NºdesanosTP=111=NºpredichospositivosTN=310=Nºpredichosnegativos

Sensibilidad=111115=0,9652=96,52%Especificidad=310311=0,9968=99,68%

La sensibilidad real y la especificidad real no la conocemos ya que con otros paciente habría dado unos resultados distintos, por ello se calcula el intervalo de confianza que nos dice que ese intervalo con un 95% de probabilidad tendrá dentro el valor buscado.

Siguiendo con el test de covid los intervalos de confianza mostrados son:

Sensibilidad=[91,33%‑99,04%]Especificidad=[98,22%‑99,99%]

Es decir que:

- El intervalo de confianza de [91,33%‑99,04%] tiene una probabilidad del 95% de contener al valor real de la Sensibilidad

- El intervalo de confianza de [98,22%‑99,99%] tiene una probabilidad del 95% de contener al valor real de la Especificidad

Cálculo del intervalo de confianza

Hay varias formas de calcular el intervalo de confianza, en el ejemplo de COVID se usa Clopper-Pearson.

Para calcular esos intervalos se necesitan los siguientes datos:

- Tamaño de la muestra o número de intentos: Realmente es el denominador de nuestra métrica

- Número de éxitos o de positivos: Realmente es el numerador de nuestra métrica

- Nivel de confianza: Suele ser el 95% pero podría ser cualquier valor , aunque si se cambia debería ser un valor mayor aun para estar más seguro.

La forma de calcular los intervalos de confianza es:

- Mediante la siguiente página web: Calcular límites de confianza para una proporción muestral

- Mediante la función

proportion_confintde python: statsmodels.stats.proportion.proportion_confint

Desgraciadamente hay varios formas de calcular el intervalo de confianza, los vamos a nombrar ahora y tambien como se llaman en la función de proportion_confint.

| Nombre | Nombre en proportion_confint |

|---|---|

| Aproximación normal (Wald) | normal |

| Clopper-Pearson exacto basado en la distribución Beta | beta |

| Wilson | wilson |

| Jeffreys con pior Beta(0.5, 0.5) | jeffreys |

| Agresti-Coull | agresti_coull |

Veamos un ejemplo en Python que calcula todos los intervalos de confianza para todos los tipos:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 |

from statsmodels.stats.proportion import proportion_confint# Número de éxitossuccess = 111# Número total de ensayostotal = 115# Nivel de confianza deseadoconfianza=95methods=['normal','beta','wilson','jeffreys','agresti_coull']for method in methods: lower, upper = proportion_confint(success, total, alpha=1-(confianza/100), method=method) print(f"Intervalo de confianza al {confianza}% con el método \"{method}\"= [{lower:.4f}, {upper:.4f}]") |

Y el resultado es:

Intervalo de confianza al 95% con el método "normal"= [0.9317, 0.9987] Intervalo de confianza al 95% con el método "beta"= [0.9133, 0.9904] Intervalo de confianza al 95% con el método "wilson"= [0.9140, 0.9864] Intervalo de confianza al 95% con el método "jeffreys"= [0.9194, 0.9881] Intervalo de confianza al 95% con el método "agresti_coull"= [0.9111, 0.9893]

Y podemos observar que el cálculo del intervalo del test de COVID se hizo con Clopper-Pearson

Elección del método

De forma general y sin querer entrar en detalles el método que deberemos usar en las métricas será el Jeffreys (jeffreys)

¿Porque Jeffreys? Porque es el que usa estadística bayesiana para calcular el intervalo de confianza. Así que realmente no es un intervalo de confianza sino un intervalo de credibilidad. ¿cual es la diferencia? Vamos a explicarlo con el ejemplo que estamos usando:

- Intervalo de confianza de

Clopper-Pearsonde[0.9133, 0.9904]significa que hay un 95% de probabilidad de que ese intervalo contenga al valor real que estamos buscando. - Intervalo de credibilidad de

Jeffreysde[0.9194, 0.9881]significa que hay un 95% de probabilidad de que el valor real que estamos buscando esté en ese intervalo. Es decir, que el valor real es una variable aleatorio y cada valor posible tiene una probabilidad. Y el intervalo de credibilidad es el conjunto de valores reales cuya probabilidad es el 95%.

En el siguiente código se puede ver como da el mismo resultado usando proportion_confint(method="jeffreys") que calculándolo mediante el teorema de bayes y usando como prior una Beta(0.5,0.5). Y por lo tanto Jeffreys es un Intervalo de credibilidad ya que es lo que se calcula en la estadística bayesiana.

NOTA:La explicación del cálculo bayesiano va más allá del ámbito de este curso de especialización.

1 2 3 4 5 6 7 8 9 10 11 12 13 |

from scipy.stats import betafrom statsmodels.stats.proportion import proportion_confintsuccess=111total=115confidence=0.95lower,upper=proportion_confint(success,total,method="jeffreys",alpha=1-confidence)print(f"Intervalo de confianza usando \"Jeffreys\"\t\t\t=[{lower:.6f} - {upper:.6f}]")beta_a=0.5+successbeta_b=0.5+total-successlower,upper=beta.interval(confidence,beta_a,beta_b)print(f"Intervalo de confianza usando Bayes con prior Beta(0.5,0.5)\t=[{lower:.6f} - {upper:.6f}]") |

Intervalo de confianza usando "Jeffreys" =[0.919431 - 0.988148] Intervalo de confianza usando Bayes con prior Beta(0.5,0.5) =[0.919431 - 0.988148]

¿Y cuando se podrían usar otros? El resto no son bayesianos así que dan "peor" información pero en lineas generales, podemos decir que:

- Clopper-Pearson o Jeffreys: Tamaño de muestra pequeño

- Wilson o Agresti-Coull: Tamaño de muestra grande y proporción no extrema

- Normal (Wald): No es recomendable

Comparación de métricas

La mayor utilidad del cálculo del intervalo de confianza es la comparación de las métricas entre distintos modelos y así saber si los modelos realmente tienen las mismas métricas.

Para ello seguiremos la siguiente regla:

- Dos modelos tienen la misma métrica si sus intervalos se solapan en algún punto

- Dos modelos tienen distinta métrica si sus intervalos no se solapan en ningún punto

- En caso de "empate", se elige el modelo con la menor variabilidad

Veamos un ejemplo.

Supongamos que tenemos la sensibilidad de 5 modelos y queremos saber si realmente son iguales o no. Los intervalos de confianza de la sensibilidad de los 4 modelos son:

Modelo1=[0.9678,0.9856]Modelo2=[0.9464,0.9789]Modelo3=[0.8567,0.9126]Modelo4=[0.7986,0.8934]Modelo5=[0.9245,0.9403]

Podemos comparar los valores pero es mejor mostrarlos en una gráfica para ayudarnos en el trabajo.

Se puede apreciar que:

- Los modelos 1 y 2 son iguales aunque es mejor el 1 ya que tiene menor variabilidad.

- Los modelos 3 y 4 son iguales aunque es mejor el 3 ya que tiene menor variabilidad.

Por lo que el orden de los modelos de mejor a peor es: 1, 2, 5, 3 y 4

La siguiente función en Python crea un gráfico para poder comparar intervalos de confianza:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 |

def plot_intervals(axes,intervalos,title,xlabel,ylabels): for index, (inferior, superior) in enumerate(intervalos): position=len(intervalos)-index-1 media=((superior-inferior)/2)+inferior axes.plot([inferior, superior], [position, position], marker='|', markersize=10, linestyle='-', color='#003B80') axes.scatter(media, position, color='#003B80') axes.set_yticks(np.arange(len(ylabels))) axes.set_yticklabels(ylabels[::-1]) axes.set_xlabel(xlabel) axes.set_title(title) axes.set_facecolor("#F0F7FF") axes.grid(visible=True, which='major', axis='both',color="#FFFFFF",linewidth=1) |

Y para crear la gráfica de nuestro ejemplo se llamaría así

1 2 3 4 5 6 7 8 9 10 11 12 13 |

figure=plt.figure()axes = figure.add_subplot()intervalos=[ [0.9678,0.9856], [0.9464,0.9789], [0.8567,0.9126], [0.7986,0.8934], [0.9245,0.9403]]ylabels=['Modelo 1', 'Modelo 2', 'Modelo 3', 'Modelo 4', 'Modelo 5']plot_intervals(axes,intervalos,"Comparación de modelos","Sensibilidad",ylabels) |

Otra forma de hacer el gráfico es poner lineas en los extremos de los intervalos, que aunque se ve mejor, queda un gráfico muy recargado.

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 |

def plot_intervals_with_guides(axes,intervalos,title,xlabel,ylabels): for index, (inferior, superior) in enumerate(intervalos): position=len(intervalos)-index-1 media=((superior-inferior)/2)+inferior color=next(axes._get_lines.prop_cycler)['color'] axes.plot([inferior, superior], [position, position], marker='|', markersize=10, linestyle='-', color=color) axes.scatter(media, position, color=color) axes.plot([inferior, inferior], [0, len(intervalos)-1], linewidth=0.5, linestyle='dashed', color=color) axes.plot([superior, superior], [0, len(intervalos)-1], linewidth=0.5, linestyle='dashed', color=color) axes.set_yticks(np.arange(len(ylabels))) axes.set_yticklabels(ylabels[::-1]) axes.set_xlabel(xlabel) axes.set_title(title) axes.set_facecolor("#F0F7FF") axes.grid(visible=True, which='major', axis='both',color="#FFFFFF",linewidth=1) |

Comparación avanzada de métricas

En caso de que los intervalos se solapen, no significa exactamente que tengan la misma métrica. Para saber si realmente la tienen es necesario restar las distribuciones y ver si el cero (o algo cercano al cero) está en dicha resta.

Para hacer los cálculos vamos a crear una serie de funciones en python.

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 |

def get_hdi(sample, hdi_prob): """ Calculation of 100(1-a)% HDI for sample Chen-Shao HPD Estimation algorithm """ smpl = np.sort(sample) n = len(smpl) ckW = max(smpl) - min(smpl) cki = 0 RB = int(n * (hdi_prob)) L0 = 0 U0 = n-1 while (RB + cki < n): if smpl[RB + cki] - smpl[cki] < ckW: ckW = smpl[RB + cki] - smpl[cki] L0 = cki U0 = RB + cki cki += 1 ckW = max(smpl) - min(smpl) cki = 1 LB = n - int(n * (hdi_prob)) L1 = 0 U1 = n-1 while (LB - cki >= 0): if smpl[n - cki] - smpl[LB - cki] < ckW: ckW = smpl[n - cki] - smpl[LB - cki] U1 = n - cki L1 = LB - cki cki += 1 return [smpl[int((L1+L0)/2)], smpl[int((U1+U0)/2)]]def get_interval(success,total,confidence=0.95): beta_a=0.5+success beta_b=0.5+total-success actual_beta=beta(beta_a,beta_b) hdi=get_hdi(actual_beta.rvs(100000),confidence) return hdidef get_hdi_compare(success1,total1,success2,total2,confidence=0.95): beta_a1=0.5+success1 beta_b1=0.5+total1-success1 beta1=beta(beta_a1,beta_b1) beta_a2=0.5+success2 beta_b2=0.5+total1-success2 beta2=beta(beta_a2,beta_b2) n_samples = 100000 datos1=beta1.rvs(n_samples) datos2=beta2.rvs(n_samples) resultado=datos1-datos2 lower,upper=get_hdi(resultado,confidence) return [lower,upper] |

Lo primero es que hemos creado la función get_interval que nos retorna el intervalo de credibilidad (en este caso el Highest Density Interval o HDI ). Calculamos ambos intervalos y los mostramos:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 |

TP1=131FN1=16TP2=124FN2=23interval1=get_interval(TP1,TP1+FN1)interval2=get_interval(TP2,TP2+FN2)figure=plt.figure(figsize=(5.5, 3))axes = figure.add_subplot()intervalos=[ interval1, interval2]ylabels=['Modelo 1', 'Modelo 2'] plot_intervals(axes,intervalos,"Comparación de modelos","Sensibilidad",ylabels) |

Y para saber si realmente tienen la misma métrica simplemente ejecutamos el siguiente código:

1 |

print(get_hdi_compare(TP1,TP1+FN1,TP2,TP2+FN2)) |

[-0.029769860656823077, 0.12498680076438595]

Si el intervalo incluye al cero es que tienen la misma métrica. Y en el ejemplo como el intervalo contiene el cero es que tienen la misma métrica.

Veamos ahora otro ejemplo:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 |

TP1=131FN1=16TP2=116FN2=31interval1=get_interval(TP1,TP1+FN1)interval2=get_interval(TP2,TP2+FN2)figure=plt.figure(figsize=(5.5, 3))axes = figure.add_subplot()intervalos=[ interval1, interval2]ylabels=['Modelo 1', 'Modelo 2'] plot_intervals_with_guides(axes,intervalos,"Comparación de modelos","Sensibilidad",ylabels) |

1 |

print(get_hdi_compare(TP1,TP1+FN1,TP2,TP2+FN2)) |

[0.018992455698845223, 0.18505496723415582]

Por lo que en este caso se solapan pero no tiene la misma métrica.

De todas en este caso, el intervalo está rozando el cero, hay un concepto llamado Region of Practical Equivalence (ROPE) que dice que aunque no esté el cero en el intervalo, nos vale una región cercana al cero ya que de forma práctica es como si fuera el cero.

Mas información:

Ejercicios

Ejercicio 1

Mirando el test de COVID de sars-cov-2_rapid_antigen_test_es.pdf. Usando la web Calcular límites de confianza para una proporción muestral calcula el intervalo de confianza de la especificidad y comprueba que coincide con el del prospecto.

Ejercicio 2

Mirando el test de COVID de sars-cov-2_rapid_antigen_test_es.pdf. Calcula en Python el intervalo de confianza de la especificidad y comprueba que coincide con el del prospecto.

Ejercicio 3

Crear 5 modelos distintos para el problema del cancer y para cada uno de ellos:

- Calcula las métricas de sensibilidad y especificidad.

- Calcula el intervalo de confianza de las métricas de sensibilidad y especificidad. ¿Que método se va a usar?

Tambien:

- Muestra en una gráfica el intervalo de confianza de la métrica de sensibilidad de todos los modelos

- Muestra en una gráfica el intervalo de confianza de la métrica de especificidad de todos los modelos

Ahora:

- Indica según la sensibilidad el orden de los bueno que es cada modelo (de mejor a peor).

- Indica según la especificidad el orden de los bueno que es cada modelo (de mejor a peor)

- ¿Que modelo elegirías?

Ejercicio 4

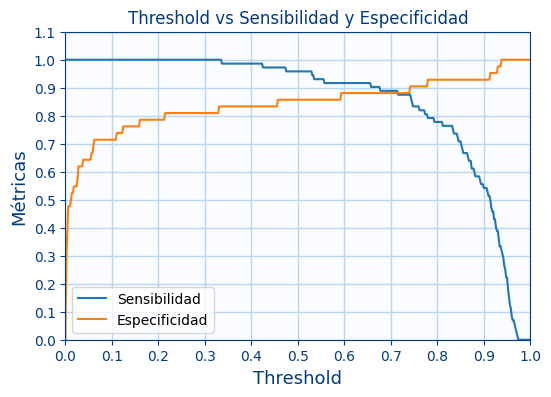

Elige el mejor de los 5 modelos anteriores y muestra ahora una gráfica, en la que se mostrará:

- El valor de la sensibilidad y la especificidad según el valor del umbral. La gráfica tendrá un aspecto simular a la siguiente:

- Repite ahora la gráfica, pero incluyendo los intervalos de credibilidad de cada métrica. La gráfica tendrá un aspecto simular a la siguiente:

Para hacer este típo de gráficas usa el método:

axes.fill_between(rango_threshold, rango_sensibilidad_lower, rango_sensibilidad_upper, color=color, alpha=0.5)

clase/iabd/pia/2eval/tema08.intervalo_confianza.txt · Última modificación: 2025/03/03 11:45 por admin

Herramientas de la página

Excepto donde se indique lo contrario, el contenido de este wiki esta bajo la siguiente licencia: GNU Free Documentation License 1.3